Archive for the tag 'fileserver'

„Fileserver“ Zusammenbau

Gestern kamen das Mainboard, CPU, RAM, Netzteil und die beiden Systemplatten hier an. Der Zusammenbau verlief ohne Probleme aber die vier 80mm Lüfter der Fanwall in der Mitte des Norco Gehäuses sind viel zu laut. Leider ist die 120mm Fanwall, die ich mitbestellt hatte, für eine andere Version meines Gehäuses und muss etwas angepasst werden. Aber da ich eh noch keine Lüfter dafür habe, hat das noch etwas Zeit.

ESX4i kommt wie schon von mir vermutet mit dem RAID1 des Mainboards nicht klar. Die Seite von der ich die Anregungen für die Hardware habe empfiehlt das Raidsonic Stardom ST2760-2S-S2B, das man auch recht günstig bekommen kann.

Ansonsten läuft die Hardware wirklich top und das IPMI Modul ist großartig. Man kann direkt von seinen ISOs starten und die iKVM Konsole ist, wenn man den Fenster Autoresize ausschaltet auch sehr gut bedienbar. ESX4i scheint auch ganz brauchbar zu sein.

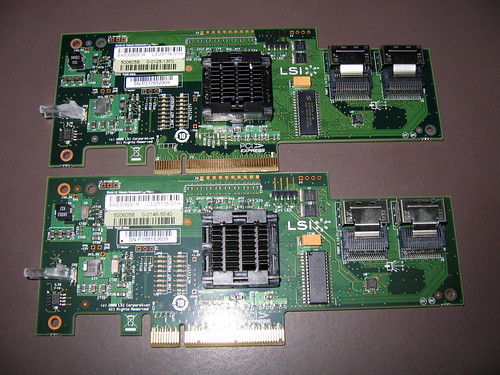

Heute kamen dann total unerwartet noch die zwei SAS-Controller an. Ich musste noch 15€ Zoll nach zahlen aber bin trotzdem noch mit zwei Controllern unter dem Preis den ich hier für einen Intel SASUC8I hätte zahlen müssen. Die Controller habe ich gerade eben auf die LSI IT-Firmware umgeflascht, damit die Platten als JBOD im Nexenta erkannt werden. Wie das mit dem Flashen am einfachsten funtkioniert habe ich hier dokumentiert.

Was jetzt noch fehlt sind die Festplatten, die 8087-Kabel, Lüfter für die andere Fanwall und so ein RAID1 Gehäuse für die Systemplatten.

„Fileserver“ Hardware endlich bestellt

Ich hab nun endlich den ersten Schwung der Fileserver Hardware bestellt. Das Gehäuse wurde das Norco RPC-4220 von www.ri-vier.nl (hier noch ein Video von XCaseUK, das Gehäuse sollte baugleich sein). Die SAS-Controller wurden die IBM BR10i, die fast baugleich zu den Intel SASUC8I sind. Ich konnte gleich zwei davon im Paket sehr günstig in Israel bestellen. Mal sehen, ob die auch ankommen. 😉

Die Systemplatten sind nun zwei 250GB 2,5″ WD Black Platten, die an den SATA-Controller des Mainboards angeschlossen werden und als RAID1 laufen sollen. Das RAM kommt von Transcent und ist einfaches ECC RAM, ich habe überlegt registered RAM zu kaufen aber ich werde wohl erst mal nicht mehr als 16GB brauchen.

Die Festplatten kaufe ich erst, wenn ich sicher bin, dass der Rest gut zusammen spielt. Es werden jetzt wohl Seagate 5900.11 oder 5900.12 mit 2TB, die sollten ok sein. Außerdem will ich die drei 640GB Platten aus dem alten Fileserver um eine weitere ergänzen und weiter benutzen. Das geht aber erst, wenn die anderen vier Platten eingebaut und die Daten migriert sind.

Abenteuerlich wird wohl noch das Flashen der LSI JBOD Firmware auf die SAS-Controller, das wäre aber beim Intel Controller ebenso nötig gewesen. Dazu gibt es kein Linux Tool, aber man kann wohl FreeDOS benutzen. Ich werde berichten.

„Fileserver“ Hardware

Nach langer Suche habe ich nun die grobe Hardwareliste für meinen neuen „Fileserver“ zusammen.

- Supermicro X8SIL-F

- Intel Xeon UP X3440

- Kingston ValueRAM DIMM Kit 8GB ECC

- Intel SASUC8I

- mehrere Hitachi 2TB Deskstars

- 160gb 2,5″ Bootplatte, evtl. auch zwei im RAID1 Verbund

Das ist natürlich für einen Fileserver etwas überdimensioniert, der Rechner soll später mit ESX4i laufen. Die erste VM ist dann ein Nexenta, das den SAS-Controller per Intel vti-d von ESX4i durchgereicht bekommt und ihn dann direkt ansprechen kann. Die anderen VMs liegen dann entweder auf dem ZFS-Storage, das Nexenta bereitstellen wird, oder auf der Bootplatte.

Am Mainboard finde ich das integrierte KVM-over-IP Modul sehr nett, damit kann man auch mal aus großer Entfernung ein ISO einbinden und davon booten. 😉 Die CPU ist auch sparsamer als sie auf den ersten blick aussieht. Sie hat in etwa den gleichen Idle-Energiebedarf wie die sparsamen Xeon UP der L-Serie aber einen höheren Bedarf unter Last, dafür sind sie auch ein gutes Stück schneller und die Kosten halten sich in Grenzen.

Mein Hauptproblem ist im Moment eigentlich nur noch ein passendes Gehäuse zu finden. Erst wollte ich ein Sharkoon Rebel9 Eco und ein paar Sata Wechselrahmen nehmen aber das passt nicht mehr so gut zum Projekt. Chenbro 19″ Gehäuse mit 8 Sata-Hot-Swap Rahmen sind teuer und vor allem Laut. Eigentlich wollte ich auch für die Zukunft gewappnet sein und 16 Rahmen für Festplatten haben. Das Mainboard hat ja immerhin noch einen weiteren PCIe 8x Steckplatz frei, in den ein weiterer Intel SASUC8I passen würde. Norco bietet ein paar schöne, günstige Gehäuse an, die man auch recht leise bekommen kann. Leider gibt es die hierzulande nirgends zu kaufen. 🙁

Man müsste also importieren…

Festplatten

Vielleicht fange ich diesen Monat an die Hardware für mein Fileserverupgrade zu beschaffen. Ich habe mich schon etwas umgesehen und wenn man bei Alternate so die Bewertungen zu den Festplatten liest, könnte man meinen alles >1TB und <9cent/GB taugt nichts.

Da wären einmal die 2TB Hitachi Deskstar 7K2000 für 129€/Stück. Da ich drei Stück brauchen werde, ist das schon mal etwas heftig. Die Platte schneidet aber noch relativ gut bei den Bewertungen ab, wäre aber etwas laut. Sie macht 7200rpm und soll auch recht schnell sein. Hitachi gibt sie für den 24/7 Betrieb frei.

Dann kommt Seagate mit der 1,5TB Barracuda 7200.11. Auch die macht 7200rpm, hat aber keine wirkliche 24/7 Freigabe. Seagate hatte vor einem Jahr ziemlich böse Firmwareprobleme. Allerdings laufen drei 640GB Seagate Platten, die jetzt zwar nicht von der Firmwareproblematik betroffen waren, aber zumindest mal aus dem problematischen Zeitraum kommen, ohne Probleme in meinem derzeitigen Fileserver. Die waren auch aus der 7200.11 Serie. Die schlechten Bewertungen bei Alternate erkläre ich mir durch den FUD der damals verbreitet wurde. Die Teile würden 90€ kosten, womit die Platten schon mal unter 300€ lägen, was ok ist.

Als Letzte kommt die WD Green mit 1,5TB in Frage, die dreht variabel mit 5400-7200. Die sind allerdings aufgrund eines etwas aggressiven Managements nicht wirklich für Raids geeignet, da sie gerne mal einschlafen und dann eine halbe Ewigkeit zum Aufwachen brauchen. Diese Problem kann man jedoch zumindest bei der EADS Reihe mit dem WDIDLE Tool (sucht bei google) beheben, indem man die Zeit in der die Platte idlen kann erhöht. Auch hier liegt der Preis bei 90€/Platte. Die schlechten Bewertungen sind wohl auf das komische Powermanagement zurück zu führen, was die Platte zu meinem Favoriten macht.

Ok, vergesst das alles, WD scheint da größere Probleme zu haben. Und zwar brauchen die nicht nur eine Ewigkeit zum Aufwachen sondern jagen auch durch eine 8 Sekunden Idle-to-Park-Zeit auch den Load-Cycle-Count in die Höhe, so dass er auf unixoiden Systemen schon nach wenigen Monaten die von WD garantierte 300k Grenze durchbricht. Ob das WDIDLE Tool bei allen Festplatten funktioniert, scheint nicht so ganz klar zu sein.

Wenn ihr schon Erfahrungen mit diesen Platten habt, sagt mir bitte mal, was ihr denkt.

Fileserverupgrades

Eigentlich wollte ich meinen jetzt fast 1,5 Jahre alten Fileserver demnächst upgraden. Es sollten 2x 1,5TB Festplatten zu den schon vorhandenen 3x 640GB dazu kommen und ich wollte von Ubuntu auf Opensolaris umsteigen. Opensolaris deshalb, da es dort das großartige ZFS gibt. Ich habe mich auch schon eingelesen und dachte das würde alles meinen Vorstellungen entsprechen, bis dann ein wichtiges Feature fehlte.

Und zwar verwaltet zfs Laufwerke als sog. vdevs (Virtual Devices), das können einzelne Platten, Mirrors (raid1) oder ein raid-z (raid5, raid5 usw.) aus mehreren Platten sein. Diese vdevs werden nun in Pools verwaltet. Ein Pool besteht also aus einem oder mehreren vdevs. Das Problem ist nun folgendes, will man mehr Speicher in seinen Server einbauen, ist das erstmal kein Problem, nur die Art wie es gemacht wird ist etwas unpraktisch für meine Zwecke.

Ich erkläre mal an einem Beispiel wie das läuft: man hat 3 Platten in seinem Solaris Server. Diese 3 Platten werden als raid-z Verbund als ein vdev in einen Pool, der sich „Daten“ nennt aufgenommen. In dem Pool erstellt man dann seine Filesysteme, Snapshots und was sonst noch alles und alle sind glücklich. Eines Tages wird der Platz knapp und man will eine 4. Festplatte einbauen. Jetzt wäre es schön, wenn man das vdev erweitern könnte, aber das geht nicht. Man kann nur den Pool erweitern.

Was bedeutet das nun?

Wenn ich den Server erweitern will, habe ich nun folgende Möglichkeiten:

- Ich lege ein vdev mit der einen neuen Platte an und füge sie dem Pool „Daten“ hinzu.

Damit verliere ich keinen Speicher aber verzichte ich auf Redundanz. Die alten Platten laufen im raid-z Verbund, es kann also eine ausfallen. Wenn die eine neue ausfällt, sind die Daten futsch. Ob dann der ganze Pool hin ist, weiß ich nicht, aber ich nehme es mal an. - Ich muss mehr als eine Platte einbauen und sie zusammen als vdev dem Pool hinzufügen.

So ist das von Sun gedacht. Nur hat man dann folgende Probleme… 1. man muss mehr Geld ausgeben, 2. man verliert unnötig Kapazität (kauft man zwei Platten verliert man 50% der neuen Kapazität + 33% Kapazität des alten vdevs aus drei Platten für die Ausfallsicherheit; kauft man drei Platten sind es trotzdem 33% des neuen + 33% des alten Verbunds), 3. hat man evtl. gar nicht die Möglichkeit mehr als eine Platte einzubauen, da der „physikalische Raum“ dafür nicht ausreicht. - Die letzte Möglichkeit wäre nun ein Backup anzulegen, den Pool und die vdevs zu zerstören und einen neuen Pool mit einem neuen vdev mit 4 Platten anzulegen. Wenn man genug Platz für ein vollständiges Backup hat, mag das machbar sein. Ich finde es nur extrem unschön.

Trotzdem würde ich gerne ZFS einsetzen,da mir die Konstruktion auf Linux im direkten Vergleich einfach nicht gefällt. Z.B. ist das Erweitern eines Softwareraids dort erstmal kein großes Problem, aber dann muss man das Filesystem vergrößern. Und will man Features wie Snapshots oder mehrere Filesysteme auf dem Raid, muss man sich noch mit LVM herumschlagen. Das ist zwar der Unix way aber bei ZFS gibts alles schön aufeinander abgestimmt in einer Box. 🙂

Hier noch ein paar Erfolgsgeschichten… A Home Fileserver using ZFS, Building my ZFS-Fileserver, OpenSolaris als Fileserver.

Interessant sind auch die Demos bei Sun, dort sieht man dann, wie einfach das alles sein kann.